oleg.milantiev.com

Сайт Олега Милантьева

Сайт Олега Милантьева

Вот пришла и моя очередь кричать «аларма!!! ИИ отжимает мой хлеб!» 🙂

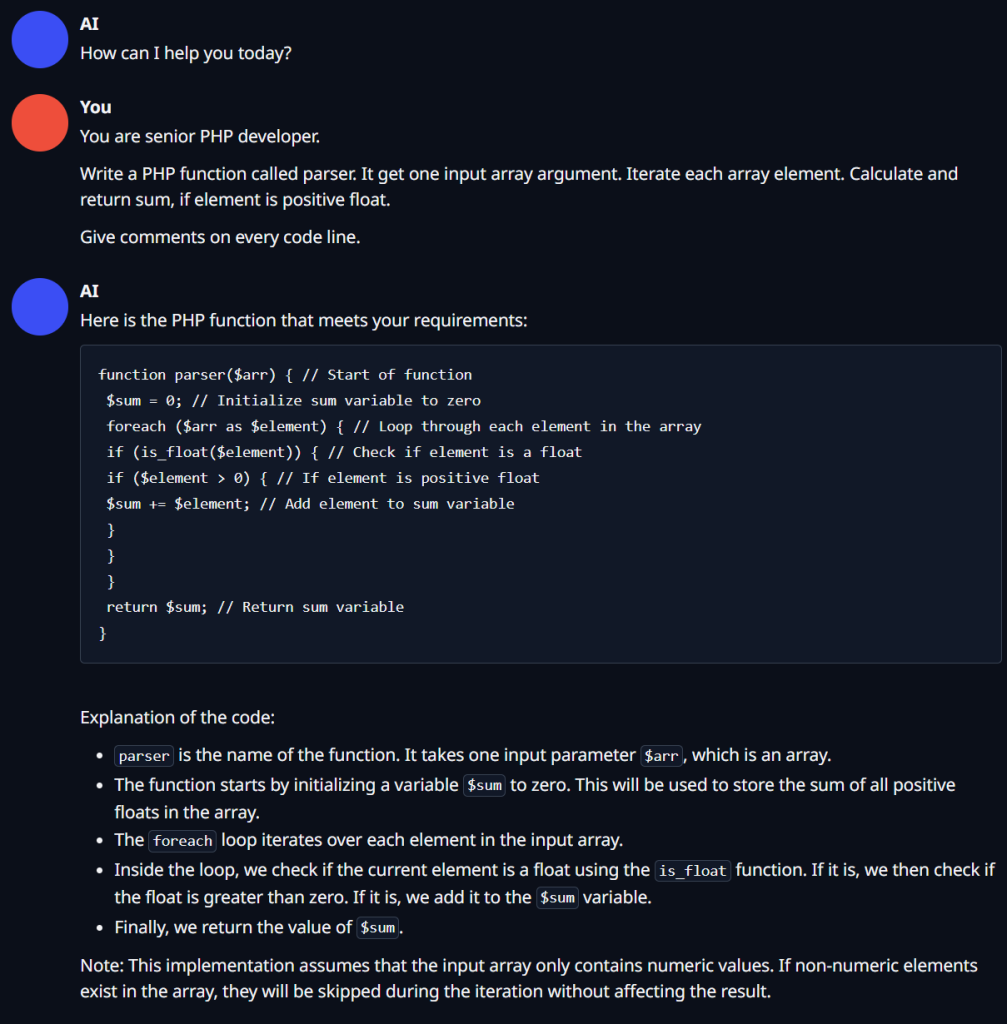

Шутки шутками, но сегодня я получил такой ответ от локально установленной софтины, о которой поведу речь далее:

Этот пример был сгенерён на i3-8100 / 32 Гб / Nvidia Tesla M40 24 Гб.

Output generated in 446.70 seconds (0.69 tokens/s, 306 tokens, context 180, seed 754130111)

Карточка (тесла) старенькая, стоила на али 10к руб с доставкой. Встроенного охлаждения у неё нет, так что грубо тыщу ещё на внешнее крепление и пару 40х40 турбин.

Использовалась общая (не программерская) языковая модель (о софте и моделях далее) с 30 млрд. параметров. Название модели: TheBloke/Wizard-Vicuna-30B-Uncensored-GPTQ.

Я уже около полугода изучаю нейросети. В основном напираю на локальное их использование. Что такое нейросеть? Какие они бывают? Что можно получить на большом-большом чужом компе? А что на моём средненьком?

Сначала я изучал детектор видео и аудио. Могу классифицировать картинку «это кот». Могу указать, где именно кот. Могу сегментировать, то есть разделить картинку, понять где дорога, где небо. Распознать голос могу. С помощью NLP (Natural Language Processing) моя программа сможет понять о чём идёт речь.

Потом я перешёл к генеративным сетям. Началось с картинок. Поставил себе Stable Diffusion и получил что-то вроде этого видео со мной: https://www.youtube.com/shorts/1LM50U64F3U

А вчера, можно сказать впервые, опробовал LLM (Large Language Model). Генерация текстов на основе огромных объёмов «прочитанных» нейросетью чужих текстов. Так сказать, Т9 на гиперстероидах!

Начало здесь: https://github.com/oobabooga/text-generation-webui?tab=readme-ov-file. Ставим эту софтину. Модель выбираю и качаю здесь: https://huggingface.co/models?pipeline_tag=text-generation&sort=downloads . Есть модели общие, есть медицинские, есть заточенные на написание кода, есть очень узкие, есть широкие. Маленькие и огромные, неповоротливые, но жуть какие чОткие.

Я, как и положено старикану почти 50-летнему разработчику, запрыгиваю в один из последних вагонов давно едущего поезда ChatGPT и его локальных аналогов. Что ж, лучше позже, чем никогда!

Как уже упомянул, нейросетевой прогресс мчится уже не первый год. Что будет дальше? Тема очень хайповая и горячая. Нужно нырять 🙂 Что я и делаю.

Очень хочется нейросетевые продукты применять в своих разработках. Как минимум, у меня уже YOLO классификатор работает в OpenSource AllSky проекте: https://github.com/oleg-milantiev/allsky.py. Так что одно внедрение есть! Скоро построю Ведрусоход. И там тоже будет и детектор через YOLO, и оптимизатор пути через tensorflow, может что ещё навешу на него.

Вперёд! Изучать нейросети! 🙂

Страшно, очень страшно! Мы не знаем что это такое, если бы мы знали что это такое, мы не знаем что это такое!